Grammaire universelle.

Residency, Mixed media. 2025-2026.

Apprentissage machine, sculpture, installation, son.

GRAMMAIRE UNIVERSELLE

ÉTAPE 1 : 6 semaines de recherches à Sporobole - Chantier IA sonore

Avec l’avènement de la bioacoustique numérique (enregistreurs numériques que les scientifiques utilisent pour enregistrer les animaux en continu sans les perturbations liées à l’introduction d’observateurs humains dans un écosystème), on assiste à un véritable déluge de données. Celles-ci permettent depuis peu à l’IA de créer des algorithmes de traitement du langage naturel qui commencent à détecter des schémas dans la communication non humaine, nous rapprochant soudainement de l’idée d’une grammaire universelle émise par Noam Chomsky. Les recherches faites en ce sens sont en train de transformer définitivement la méthodologie anthropocentriste actuelle pour évaluer l’intelligence animale : elles ont le potentiel d’interroger notre statut et notre positionnement dans le règne animal et pour questionner notre manière d’interagir avec le vivant.

Pendant sa résidence, l’artiste explorera les développements de la traduction et des communications grâce à l’IA dans l’espoir de s’associer avec un des quatre grands groupes de recherches universitaires sur le langage des insectes et les animaux. L’exploration de leurs bases de données et l’apprentissage de leurs approches mathématiques des algorithmes lui ouvrira une perspective sur les divers enjeux méthodologiques de la traduction. Ultimement, l’utilisation d’outils génératifs lui permettra de réfléchir au concept actualisé de traduction/décodage et de constituer une banque de nouveau matériel sonore pour créer des œuvres qui abordent la communication avec le non-humain.

// Avant la résidence

J’ai ciblé quatre grands groupes de recherche sur les baleines, les oiseaux et les abeilles (CETI, EARTH SPECIES, MIT SPECTRUM, FREIE UNIVERSITÄT). Au fils des mois, j’ai suivi les développements de leurs recherches, j’ai assisté à leurs conférences en ligne où j’ai suivi leurs chercheurs. J’ai rapidement éliminé les recherches sur les oiseaux du MIT SPECTRUM parce que ces études sont concentrées principalement sur les migrations nocturnes. J’ai persisté auprès des groupes de recherches sur les baleines (CETI, EARTH SPECIES) parce qu’elles s’intéressaient au langage, et la linguistique spécifiquement. Je n’ai pas reçu de réponse de leurs part avant le début de la résidence.

// Durant les trois premières semaines de la résidence

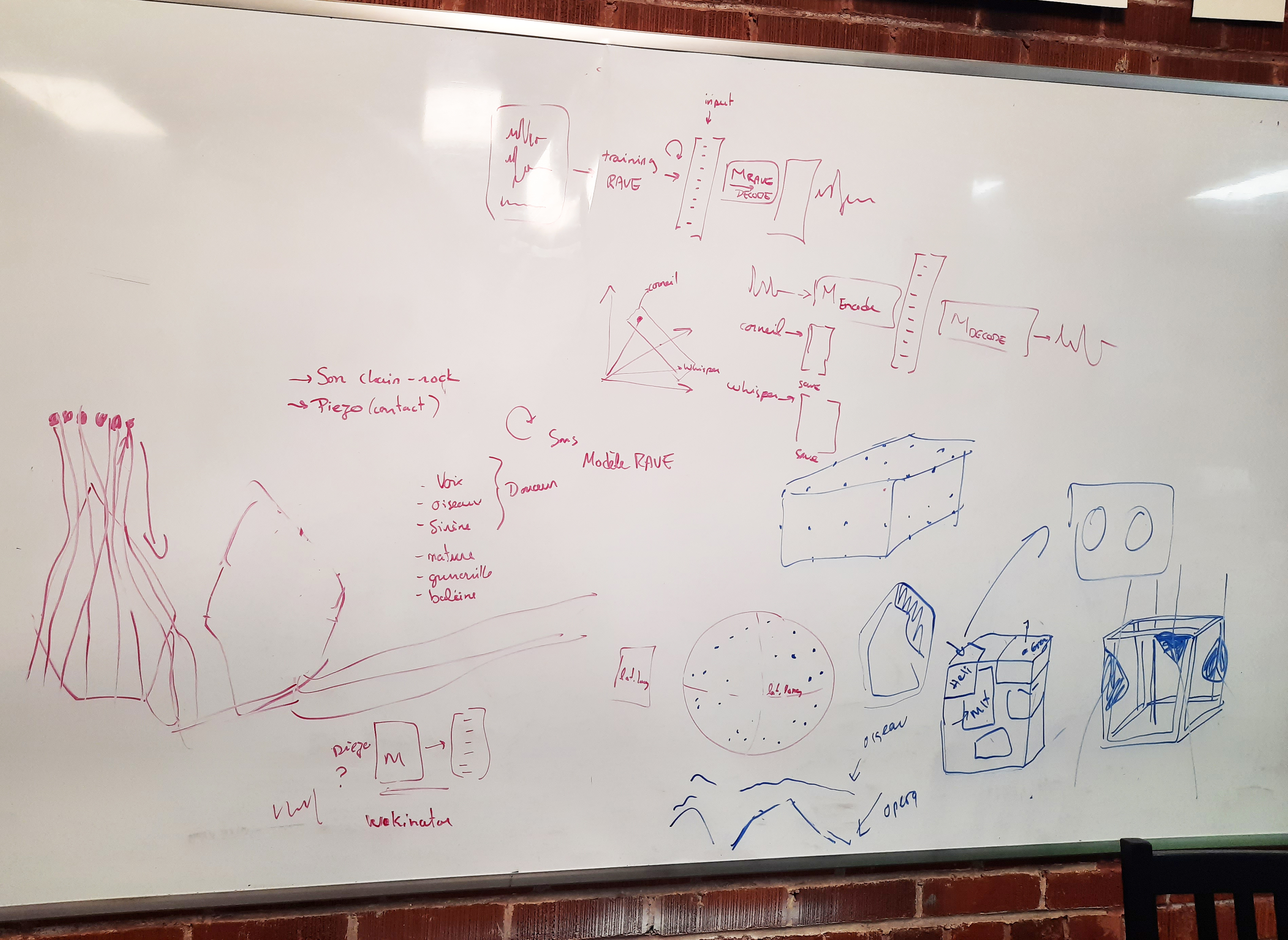

N’ayant pas reçu de réponses des deux groupes de recherche sur les baleines, j’ai repositionné ma recherche et j’ai plongé dans le vocabulaire et la structure de l’IA en me posant plusieurs questions telles que :

- Qu’est-ce que l’espace latent?

- Comment le visualiser?

- Pourquoi l’utilisation du mot espace?

- Est-il possible d’appliquer des lois de gravité à l’espace latent?

- Est-ce qu’entraîné des modèles donne de meilleurs résultats que les outils génératifs ?

- Quel est le résultat d’une interpolation entre deux sons ?

Exemple d’interpolation Rave: - Est-ce que ces sons deviennent une forme (fluide) ou deux formes superposées (gradient) ?

Exemple de grenouille - hélicoptère interpolation en couches :

Visualisation de l’interpolation![]()

- Est-il possible de cartographier les sons qui sont distribués dans l’espace latent?

- Peut-on faire l’expérience physique d’un espace latent sonore?

Le résultat de ces recherches et explorations ont mené à la réalisation de deux prototypes avec la kinect.

Spatialisation d’un espace latent sonore (oiseaux / chuchottement)

printemps 2025 - Kinect Rave

Curseur physique latéral dans l’espace latent sonore (grenouilles / hélicoptères)

printemps 2025 - Kinect StableAudio

// Avant la deuxième partie de la résidence

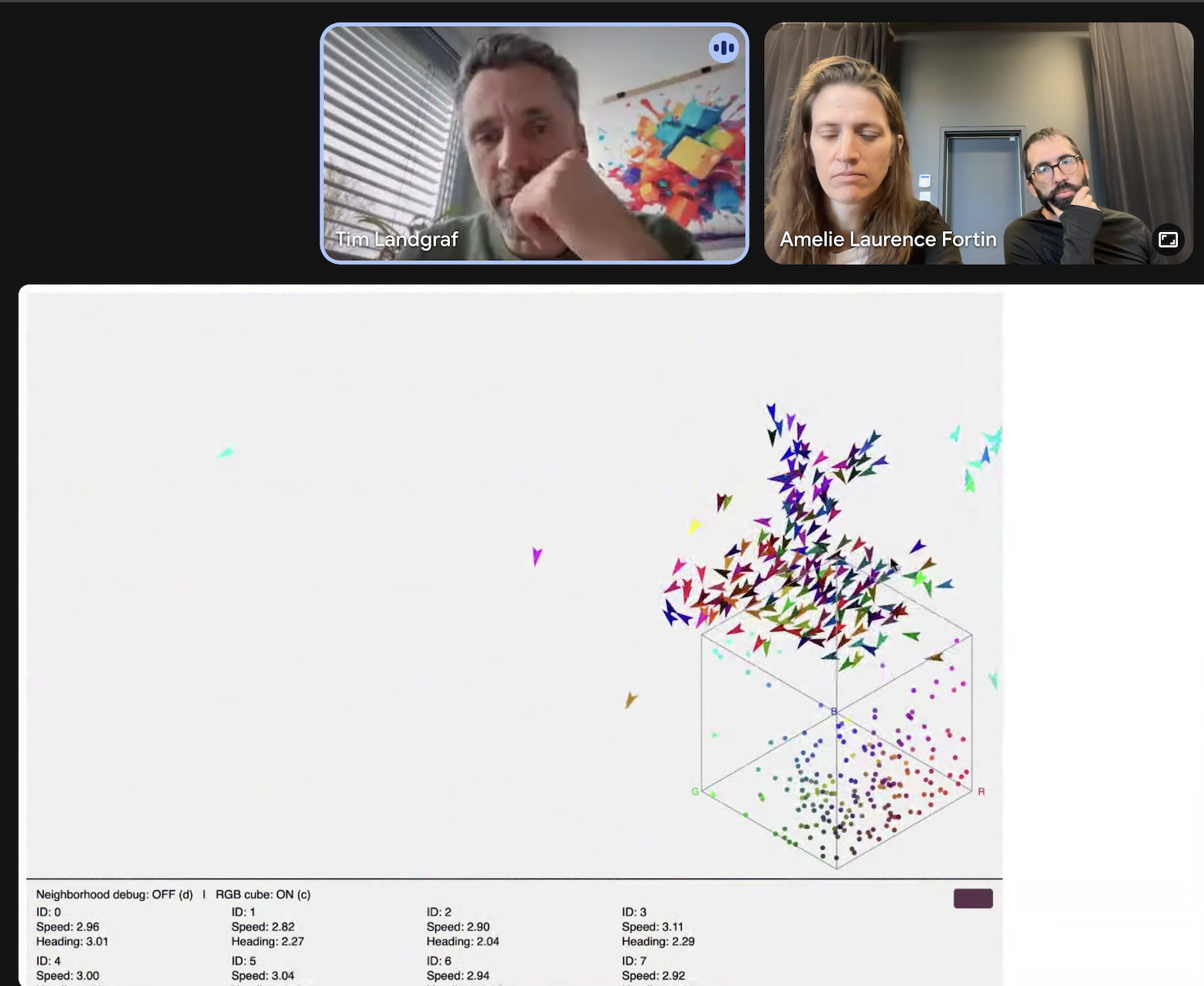

En septembre, j’ai tenté de rejoindre le dernier groupe de recherche (abeilles) avec succès. Après la visite du laboratoire du Département de mathématiques et d’informatique de l’Université libre de Berlin le 30 septembre, j’ai eu une rencontre Zoom avec Tim Landgraf le 4 octobre. J’ai alors obtenu l’accord de participation du département autour de leurs recherches sur le langage comportemental des abeilles.

https://bioroboticslab.github.io/website/research.html

// Durant les trois dernières semaines de la résidence

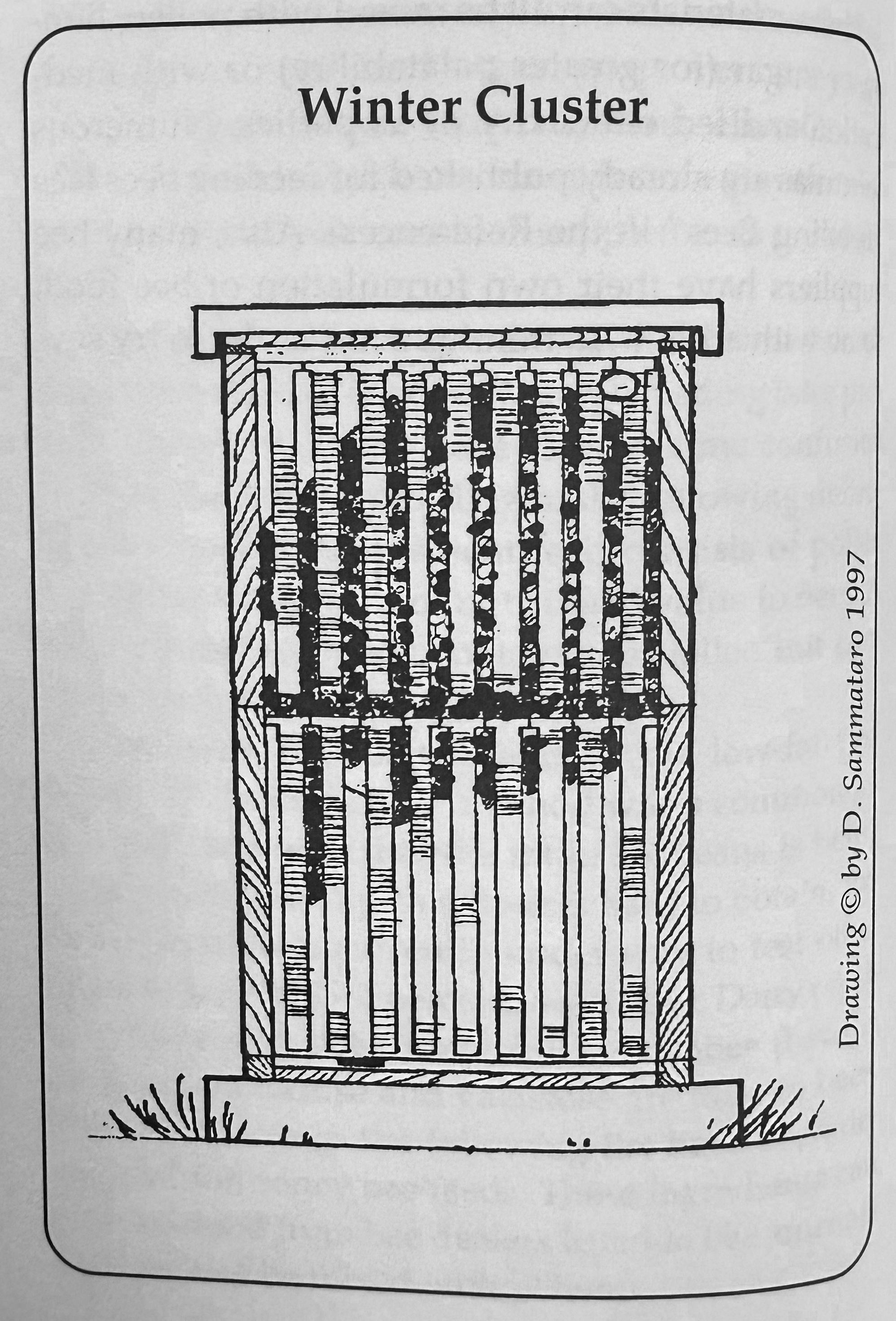

À l’arrivée à Sporobole, je me suis plongée dans la lecture sur les recherches du langage des abeilles à partir de Karl von Frisch jusqu’à Tim Landgraf afin de pouvoir maîtriser la chronologie des recherches, l’utilisation de l’IA pour les recherches actuelles et les applications concrètes espérées par le groupe de recherche de Tim Landgraf, en robotique notament. Un des défis principal de l’équipe de l’Université Libre de Berlin est de créer des modèles de traitement des données recueillies à fin d’interprétation. En raison du nombre d’individus dans une ruche et des différents comportements connus, les modèles deviennent potentiellement plus complexes à réaliser. Ce qui rappelle le théorème d’incomplétude de Gödel.

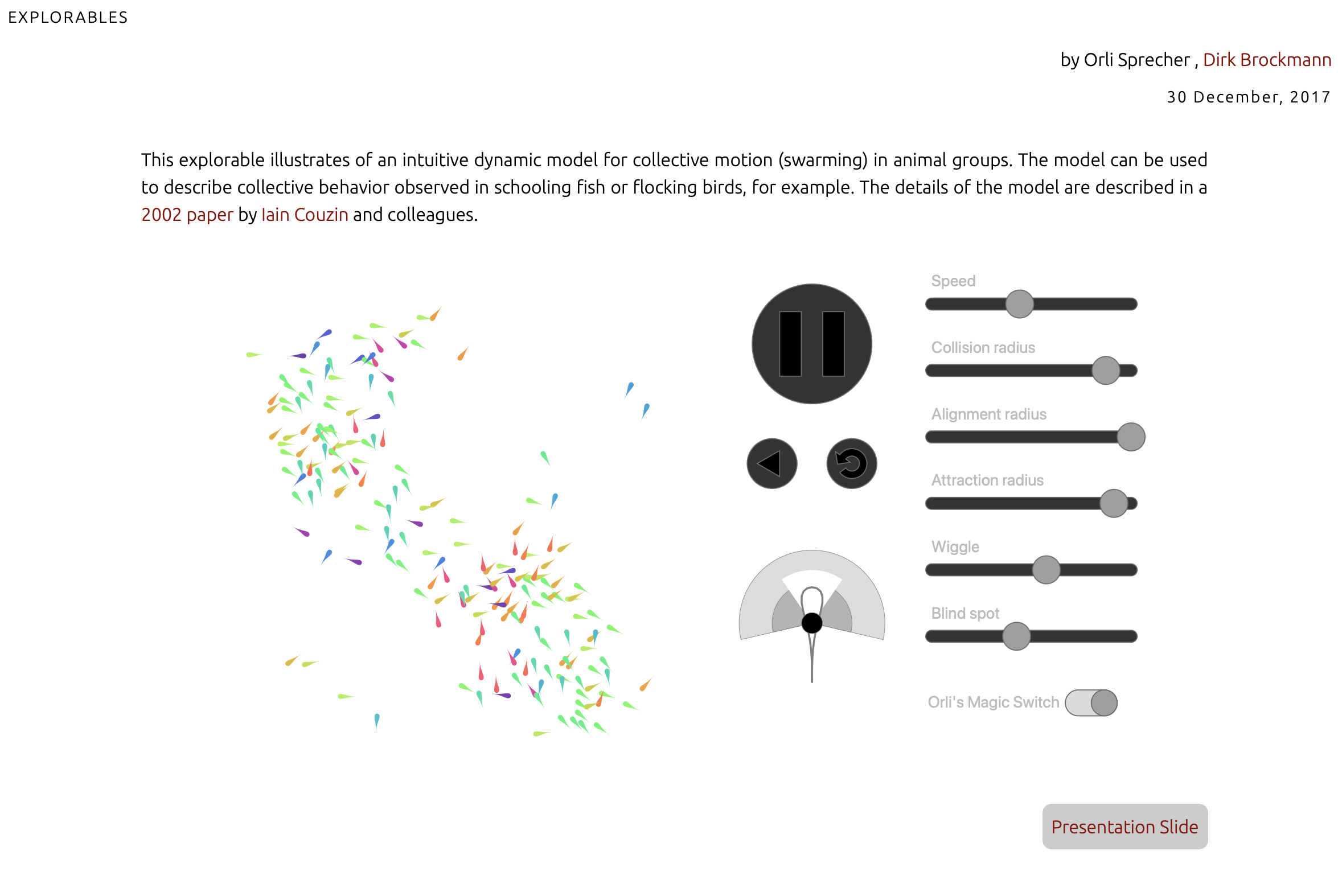

Cette plongée dans l’univers du langage des abeilles m’ont amenés à définir mon projet autour de la traduction du langage comportemental (ainsi à délaisser la traduction binaire entre vocabulaire humain-vocabulaire animal grâce) qui sont rendus possibles grâce aux développements des systèmes génératifs comme l’IA; à m’intéresser sur l’intelligence en essaim (SWARM) et à son application en robotique pour créer des système auto replicatifs et auto-correctionnels (robot Mars, voiture intelligente, etc.) ; et au sytème neuronal des abeilles dans son processus de décisions décentralisées.

Pour parfaire ma connaissance des abeilles, j’ai rencontré, par l’entremise de Vicky Chainey-Gagnon, l’apiculteur Benoît Héguy qui m’a invité à venir enregistrer ses abeilles avant le refroidissement de l’automne. J’ai testé un micro à basse fréquence, qui donnera un meilleur résultat dans la saison active de l’été.

Avec Renaud, nous avons rencontré Tim Landgraf pour officialiser la collaboration autour de ce projet et nous avons élaboré une première méthodologie de traduction des mouvements des abeilles pour générer des sons. Ce qui m’a amené à faire une charte des différentes fréquences générées par les abeilles en différentes circonstances.

![]()

Les étapes de réalisation anticipées

- Faire des modèles d’agents pour tester différentes hypotèses et choisir celles qui sont les plus intéressantes pour le projet.

- Faire des modèles à mi-chemin qui seront testés dans un prototype.

- Ajuster le modèle et le prototype.

- Réaliser l’oeuvre.

![]()

ÉTAPE 2 : Création

En collaboration avec Tim Landgraf de l’Université Libre de Berlin et Sporobole.

Exemple d’interpolation Rave:

En utilisant les systèmes d’intelligence en essaim en utilisant des agents reproduisant des comportements d’abeilles et s’inspirant des modulations de fréquences dans une ruche, et un clin d’oeil à la “boîte noire” comme espace formel d’interprétation, l’exposition sera une installation sonore portant une réflexion sur l’IA et son système neuronal.

comment